content.txt – die perfekte Ergänzung zur llms.txt

Mitten im heutigen Digital-Trubel taucht plötzlich eine unscheinbare…

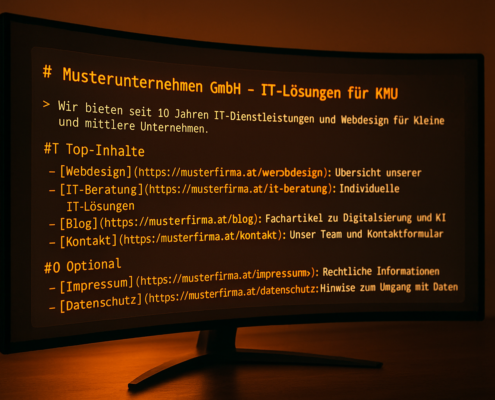

LLMs.txt: Ihr Inhaltsverzeichnis für KI-Bots

Schon mal erlebt, dass Ihre gepflegte Website im ChatGPT plötzlich verschwindet? Sie rankt weiter prima bei Google, aber in KI-Antworten werden nur die Konkurrenz und andere Quellen genannt. Will keiner hören. Was ist los? Ganz einfach: Chatbots durchsuchen das Web anders als eine klassische Suchmaschine. Und genau hier kommt llms.txt ins Spiel – eine unscheinbare Textdatei, die Ihre wichtigsten Inhalte für KI-Bots sichtbarer macht.

Überblick über aktuelle Datenschutzgesetze und deren Auswirkungen auf Marketingstrategien

Ihre neueste Marketingkampagne läuft auf Hochtouren – doch…

Deine Website bringt keine Kunden? Die häufigsten DIY-Fehler – und wie Austrianweb.at sie für dich löst

Du hast deine Website selbst erstellt, aber sie bringt kaum Besucher…

Googles neues KI-Feature: Antworten direkt im Suchergebnis

Google revolutioniert erneut die Suche: Mit einem neuen KI-Feature…

Gamechanger für SEO: Wie sich die Suchmaschinenoptimierung 2025 radikal verändert

SEO ist im Jahr 2025 wichtiger denn je, da die Art und Weise,…

Der Einfluss der Weltpolitik auf Suchergebnisse bei Google: Was SEO-Experten wissen müssen

Weltweite politische Ereignisse haben nicht nur Auswirkungen…

SEO-Trends 2025: Ein Blick in die Zukunft der Suchmaschinenoptimierung

Die digitale Landschaft verändert sich rasant, und mit ihr auch…

Bildschirmauflösungen verstehen: Die perfekte Balance zwischen Monitorgröße und Hardwareleistung

Die Welt der Bildschirmauflösungen: Was Sie wissen müssen

Die…

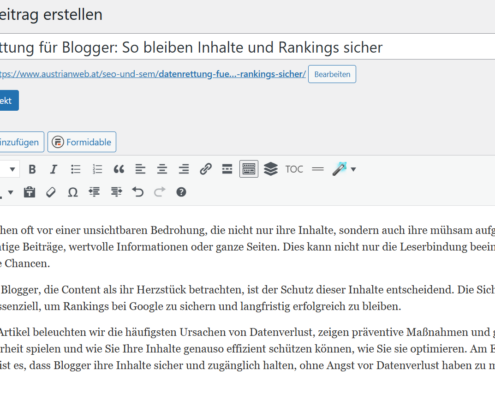

Datenrettung für Blogger: So bleiben Inhalte und Rankings sicher

Blogger stehen oft vor einer unsichtbaren Bedrohung, die nicht…

SEO und Datenverlust: So minimieren Sie den Schaden bei einem Website-Crash

Die digitale Präsenz einer Website ist heute meistens der Schlüssel…

Die Entstehung und Geschichte der Künstlichen Intelligenz

Die Geschichte der künstlichen Intelligenz (KI) ist eine faszinierende…