Die Entstehung und Geschichte der Künstlichen Intelligenz

Die Geschichte der künstlichen Intelligenz (KI) ist eine faszinierende Reise, die tief in die Wurzeln der Mathematik, Philosophie und Informatik reicht. Sie beginnt lange vor dem modernen Computerzeitalter und ist geprägt von visionären Ideen, bahnbrechenden Entdeckungen und der ständigen Frage, was Intelligenz wirklich bedeutet.

Geschichte

Die Anfänge (1940er-1950er Jahre)

Alan Turing: Der Visionär

Ein wesentlicher Meilenstein in der Geschichte der KI ist die Arbeit des britischen Mathematikers Alan Turing. In den 1940er Jahren stellte Turing die bahnbrechende Frage: “Können Maschinen denken?” Sein 1950 veröffentlichter Turing-Test wurde zu einem Standardkriterium zur Beurteilung künstlicher Intelligenz.

Der Turing Test

Der Turing-Test, entwickelt vom britischen Mathematiker und Computerwissenschaftler Alan Turing im Jahr 1950, ist ein Kriterium zur Beurteilung der Fähigkeit einer Maschine, menschenähnliche Intelligenz zu demonstrieren. Der Test wurde in Turings Aufsatz “Computing Machinery and Intelligence” beschrieben, der in der Zeitschrift “Mind” veröffentlicht wurde.

Grundprinzip des Turing-Tests

Der Turing-Test basiert auf der Idee, dass ein Computer als intelligent angesehen werden kann, wenn er in der Lage ist, menschliche Kommunikation so überzeugend zu imitieren, dass ein menschlicher Beobachter nicht unterscheiden kann, ob er mit einer Maschine oder einem Menschen kommuniziert. Der Test funktioniert folgendermaßen:

-

- Einrichtung: Es gibt drei Teilnehmer: einen Computer, einen menschlichen Befrager und einen menschlichen Respondenten.

- Kommunikation: Die Kommunikation zwischen dem Befrager und den beiden anderen Teilnehmern erfolgt über eine textbasierte Schnittstelle, um das Erscheinungsbild und die Stimme auszuschließen.

- Aufgabe des Befragers: Der Befrager stellt Fragen oder führt eine Konversation und versucht zu bestimmen, welcher der beiden Respondenten der Mensch ist und welcher die Maschine.

- Bewertung: Wenn der Befrager nicht zuverlässig feststellen kann, welcher Respondent der Computer ist, oder wenn der Computer genauso häufig für einen Menschen gehalten wird wie der menschliche Respondent, gilt der Computer als bestanden im Test.

Bedeutung des Turing-Tests

Der Turing-Test war einflussreich, weil er einen der ersten Versuche darstellte, Intelligenz bei Maschinen zu definieren und zu messen. Er führte auch zu vielen Diskussionen und Debatten über die Natur der Intelligenz, das Bewusstsein und die Möglichkeiten der künstlichen Intelligenz.

Kritik und Weiterentwicklung

Obwohl der Turing-Test als ein wichtiger Meilenstein in der Geschichte der KI angesehen wird, ist er auch Gegenstand von Kritik. Einige Experten argumentieren, dass der Test mehr über die Fähigkeit einer Maschine zur Täuschung aussagt als über ihre Intelligenz. Außerdem berücksichtigt der Test nicht die Fähigkeit zur emotionalen Intelligenz oder zum kreativen Denken.

Im Laufe der Zeit haben Wissenschaftler verschiedene Variationen und Erweiterungen des Turing-Tests vorgeschlagen, um diese Einschränkungen zu überwinden und ein breiteres Spektrum an intelligentem Verhalten zu erfassen. Trotz seiner Einschränkungen bleibt der Turing-Test jedoch ein bedeutendes Konzept in der Diskussion über künstliche Intelligenz.

Die Geburtsstunde der KI: Dartmouth-Konferenz (1956)

Der Begriff “künstliche Intelligenz” wurde offiziell 1956 von John McCarthy während der Dartmouth-Konferenz geprägt. Diese Konferenz markierte den Beginn der KI als eigenständiges Forschungsfeld und brachte Wissenschaftler wie Marvin Minsky, Claude Shannon und viele andere zusammen.

Frühe Entwicklungen (1960er-1970er Jahre)

Die Entwicklung von KI-Sprachen

In den 1960er Jahren wurden spezielle Programmiersprachen für die KI-Forschung entwickelt. Lisp, geschaffen von John McCarthy im Jahr 1958, wurde eine der führenden Sprachen in diesem Bereich.

Expertensysteme

Die 1970er Jahre sahen die Entstehung von Expertensystemen. Diese Programme simulierten das Wissen und analytische Fähigkeiten eines menschlichen Experten. Eines der bekanntesten Systeme dieser Zeit war MYCIN, entwickelt an der Stanford University, das in der Lage war, Bakterieninfektionen zu diagnostizieren und Antibiotika vorzuschlagen.

Der KI-Winter (1980er Jahre)

In den 1980er Jahren erlebte die KI-Forschung einen Rückschlag, bekannt als der “KI-Winter”. Hohe Erwartungen an die KI wurden enttäuscht, was zu einem drastischen Rückgang der Förderung führte. Dies war teilweise auf die Grenzen der damaligen Computerhardware und eine Überschätzung der Fähigkeiten von KI-Systemen zurückzuführen.

Neubeginn und Fortschritt (1990er Jahre bis heute)

Maschinelles Lernen

Mit der Verbesserung der Computerleistung und der Verfügbarkeit großer Datenmengen kam es in den 1990er Jahren zu einem Wiederaufleben der KI. Insbesondere das Gebiet des maschinellen Lernens, bei dem Computerprogramme lernen, Muster und Beziehungen in Daten zu erkennen, gewann an Bedeutung.

Deep Learning und Neuronale Netze

In den 2000er Jahren führten Fortschritte im Bereich der neuronalen Netze und des Deep Learning zu signifikanten Durchbrüchen. 2012 markierte einen Wendepunkt, als das von Geoffrey Hinton geleitete Team ein tiefes neuronales Netzwerk entwickelte, das den Wettbewerb ImageNet gewann. Diese Technologie liegt heutigen KI-Anwendungen wie Sprach- und Bilderkennung zugrunde.

KI in der Gegenwart

Heute ist KI allgegenwärtig und treibt Innovationen in nahezu jedem Sektor voran, von der Medizin über die Automobilindustrie bis hin zur Unterhaltung. KI-Systeme sind in der Lage, komplexe Aufgaben durchzuführen, die von autonomen Fahrzeugen bis hin zu personalisierten Gesundheitsdiagnosen reichen.

Die Geschichte der künstlichen Intelligenz ist eine Geschichte von Höhen und Tiefen, geprägt von bahnbrechenden Entdeckungen und vorübergehenden Rückschlägen. Von den frühen Tagen der Computerwissenschaften bis hin zur heutigen Ära des maschinellen Lernens und der neuronalen Netzwerke hat die KI stets die Grenzen dessen, was technologisch

Die Wichtigsten KI-Modelle und Anbieter von Heute

Künstliche Intelligenz (KI) hat in den letzten Jahren erhebliche Fortschritte gemacht, angeführt von einer Reihe von bedeutenden Modellen und Anbietern. Diese Entwicklungen haben die Art und Weise, wie wir über maschinelles Lernen, natürliche Sprachverarbeitung und andere KI-Technologien denken, grundlegend verändert. In diesem Artikel werfen wir einen Blick auf einige der wichtigsten KI-Modelle und ihre Schöpfer oder die dahinterstehenden Teams.

OpenAI und GPT-Modelle

GPT-3

- Entwickler: OpenAI, ein KI-Forschungslabor mit Sitz in San Francisco.

- Schöpfer/Programmierer: Ein Team von Forschern unter der Leitung von Ilya Sutskever, einem der Mitbegründer von OpenAI.

- Beschreibung: GPT-3 (Generative Pre-trained Transformer 3) ist ein hochmodernes Sprachverarbeitungsmodell, das in der Lage ist, menschenähnlichen Text zu generieren. Es wird in einer Vielzahl von Anwendungen eingesetzt, von Chatbots bis hin zu Inhaltserstellung.

DALL-E

- Entwickler: Ebenfalls von OpenAI.

- Schöpfer/Programmierer: Ein Team bei OpenAI, unter anderem von Forschern wie Aditya Ramesh und Prafulla Dhariwal.

- Beschreibung: DALL-E ist ein KI-Modell, das darauf spezialisiert ist, Bilder aus Beschreibungen in natürlicher Sprache zu generieren. Es demonstriert beeindruckende Fähigkeiten im Bereich der Kreativität und Bildsynthese.

Google und seine KI-Entwicklungen

BERT

- Entwickler: Google AI.

- Schöpfer/Programmierer: Ein Team von Forschern bei Google, darunter Jacob Devlin und Ming-Wei Chang.

- Beschreibung: BERT (Bidirectional Encoder Representations from Transformers) ist ein Modell für natürliche Sprachverarbeitung, das darauf abzielt, das Verständnis von Kontext in der Sprache zu verbessern. Es wird in Googles Suchalgorithmus verwendet und hat einen großen Einfluss auf die Suchmaschinenoptimierung.

TensorFlow

- Entwickler: Google Brain Team.

- Schöpfer/Programmierer: Das Google Brain Team, unter der Leitung von Jeff Dean und Rajat Monga.

- Beschreibung: TensorFlow ist eine Open-Source-Plattform für maschinelles Lernen und wird in einer Vielzahl von Anwendungen und Forschungsprojekten verwendet.

Andere bemerkenswerte KI-Modelle

IBM Watson

- Entwickler: IBM.

- Schöpfer/Programmierer: Ein großes Team bei IBM, geleitet von David Ferrucci.

- Beschreibung: Watson ist bekannt für seinen Sieg in der Spielshow “Jeopardy!” und ist ein Pionier im Bereich der Frage-Antwort-Systeme. Es wird in verschiedenen Branchen eingesetzt, von Gesundheitswesen bis hin zu Finanzdienstleistungen.

YOLO (You Only Look Once)

- Entwickler: Joseph Redmon und Santosh Divvala (University of Washington), Ross Girshick und Ali Farhadi.

- Beschreibung: YOLO ist ein bedeutendes Modell im Bereich der Echtzeit-Objekterkennung und hat die Art und Weise, wie Computer visuelle Daten verarbeiten, revolutioniert.

Schlussfolgerung

Die Entwicklung der KI hat eine beeindruckende Dynamik gezeigt, mit bahnbrechenden Modellen und Technologien, die ständig neu definiert werden. Von OpenAIs GPT-3 und DALL-E bis hin zu Googles BERT und TensorFlow reicht das Spektrum der Innovationen. Diese Entwicklungen sind nicht nur technische Meisterleistungen, sondern auch das Ergebnis der harten Arbeit und des Engagements vieler talentierter Individuen und Teams. Sie legen den Grundstein für eine Zukunft, in der KI eine immer wichtigere Rolle in unserem täglichen Leben spielen wird.

Wie kann künstliche Intelligenz bei der Erstellung von Webseiten helfen

Künstliche Intelligenz (KI) kann auf verschiedene Weise bei der Erstellung und Optimierung von Webseiten hilfreich sein. Durch den Einsatz von KI-Technologien können sowohl der Entwicklungsprozess beschleunigt als auch die Benutzererfahrung verbessert werden.

Hier sind einige Schlüsselbereiche, in denen KI eine Rolle spielt:

- Automatisches Webdesign: KI-gestützte Tools können das Layout, Farbschema und Design einer Webseite automatisch anpassen. Sie analysieren Best Practices und aktuelle Design-Trends, um benutzerfreundliche und ästhetisch ansprechende Designs zu erstellen.

- Personalisierung der Nutzererfahrung: KI kann das Verhalten und die Vorlieben der Nutzer analysieren und darauf basierend personalisierte Inhalte, Produktvorschläge und personalisierte Werbung anbieten. Dies erhöht die Relevanz und Effektivität der Webseite für den einzelnen Nutzer.

- Suchmaschinenoptimierung (SEO): KI-Tools können dabei helfen, die SEO-Leistung einer Webseite zu verbessern, indem sie Keywords analysieren, den Content optimieren und Vorschläge für Backlinks machen. Sie können auch Trends vorhersagen und Empfehlungen für zukünftige Inhalte geben.

- Chatbots und Kundenservice: KI-basierte Chatbots können auf Webseiten eingesetzt werden, um Besucherfragen zu beantworten, Unterstützung anzubieten und Leads zu generieren. Diese Bots können lernen und sich im Laufe der Zeit verbessern, um effektiver auf die Bedürfnisse der Benutzer einzugehen.

- Content-Erstellung und Management: KI kann bei der Generierung von Inhalten helfen, sei es durch das Schreiben von Texten, das Erstellen von Bildern oder das Vorschlagen von Content-Ideen. Sie kann auch dabei helfen, den Content zu verwalten und zu organisieren, z.B. durch automatisierte Kategorisierung und Tagging.

- Testen und Optimieren der Benutzererfahrung: Mithilfe von KI können A/B-Tests und andere Benutzertests effizienter durchgeführt werden. KI-Systeme können Muster in Benutzerdaten erkennen und Vorschläge machen, wie die Benutzererfahrung verbessert werden kann.

- Barrierefreiheit: KI kann dabei helfen, Webseiten für Menschen mit Behinderungen zugänglicher zu machen, indem sie beispielsweise Inhalte für Screenreader optimiert oder automatisch Untertitel für Videos generiert.

- Analyse und Datenverarbeitung: Durch die Verwendung von KI zur Analyse von Webseiten-Traffic und Benutzerinteraktionen können wertvolle Einblicke gewonnen werden, die zur weiteren Optimierung der Webseite verwendet werden können.

Insgesamt bietet KI ein enormes Potenzial, um den Prozess der Webseitenerstellung und -pflege zu revolutionieren, indem sie Automatisierung, Personalisierung und Effizienzsteigerung ermöglicht.

Am Sonntag, 15. September 2013

Am Sonntag, 15. September 2013

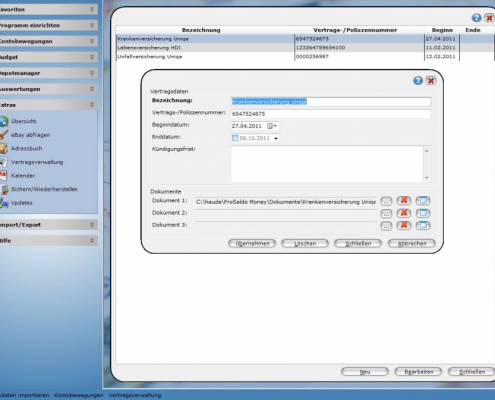

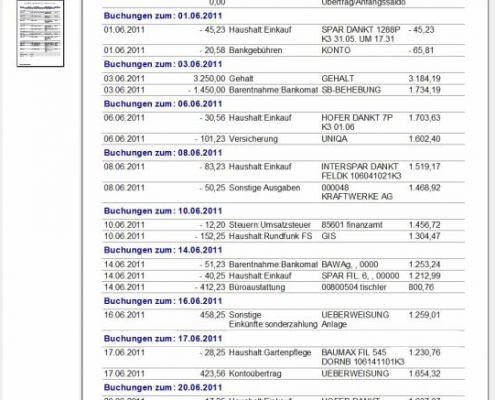

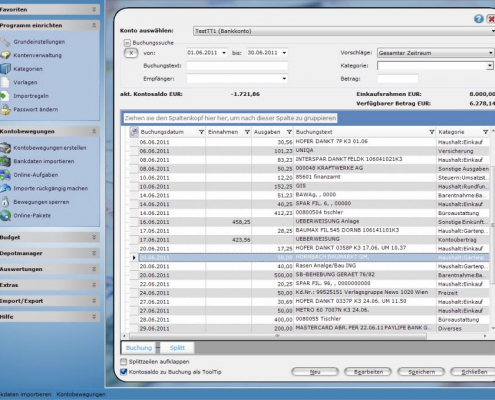

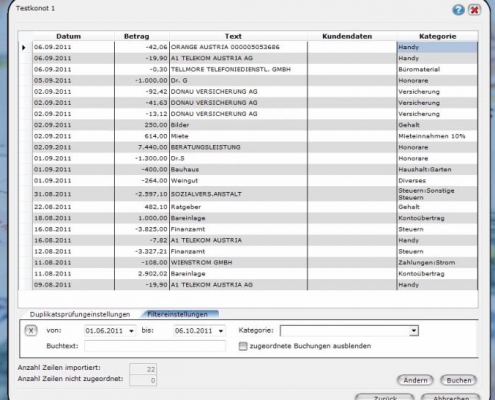

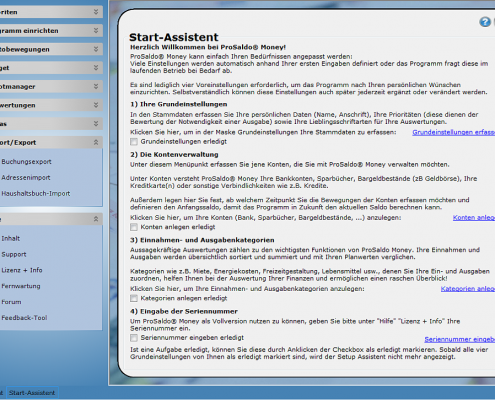

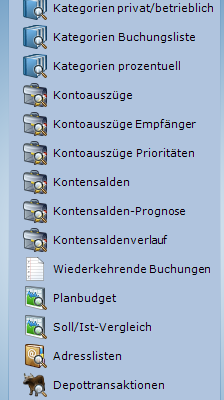

Saldo statt Soll – Wie sie ihre Finanzen sicher im Griff behalten

Saldo statt Soll – Wie sie ihre Finanzen sicher im Griff behalten

Am Sonntag, 16. September 2012

Am Sonntag, 16. September 2012 Jedes Büro braucht Toner und/oder Druckerpatronen. Dieses Verbrauchsmaterial ist wichtig und muss immer lagernd sein.

Jedes Büro braucht Toner und/oder Druckerpatronen. Dieses Verbrauchsmaterial ist wichtig und muss immer lagernd sein.