Ein halbes Jahr „Google Penguin“ – Teil 1

Teil 1 – Was war, was ist: Wenig hat sich geändert.

Sechs Monate sind mittlerweile seit April verstrichen, seit dem Google zur Verbesserung seiner Suchergebnisseiten angesetzt hatte und mit dem Algorithmus-Update Penguin eine der größten Veränderungen seiner Bewertungskriterien und der Erfassung vollkommen neuer Relevanzkriterien den Schritt wagte, sowohl den grassierenden Manipulationen von Suchergebnissen durch „schwarze SEO“ eben wie dem Webspam den Kampf ansagte – und sich damit den Unmut eines nicht geringen Anteils der SEO-Branche zuzog welche für den Erhalt des Status quo skandierte, in dessen relativer Stabilität es sich die Optimierer gemütlich gemacht hatten.

Sechs Monate sind mittlerweile seit April verstrichen, seit dem Google zur Verbesserung seiner Suchergebnisseiten angesetzt hatte und mit dem Algorithmus-Update Penguin eine der größten Veränderungen seiner Bewertungskriterien und der Erfassung vollkommen neuer Relevanzkriterien den Schritt wagte, sowohl den grassierenden Manipulationen von Suchergebnissen durch „schwarze SEO“ eben wie dem Webspam den Kampf ansagte – und sich damit den Unmut eines nicht geringen Anteils der SEO-Branche zuzog welche für den Erhalt des Status quo skandierte, in dessen relativer Stabilität es sich die Optimierer gemütlich gemacht hatten.

Welchen Impact das Update auf die SEO-Branche tatsächlich hatte, das scheint bisher unausgesprochen, als traue sich niemand das Thema auch nur mit der Zange anzufassen.

Auch ist es um die Diskussionen, die noch bis in den späten Mai hinein die Gemüter in der SEO-affinen Blogosphäre erhitzten, erstaunlich still geworden und selbst Fälle des zu erwartenden Nachtretens einzelner Blogger gegen die überwältigende wie auch unausweichliche Veränderung, welche soviel Unmut und Unruhe bei vielen „Fachleuten“ erzeugte, blieb erstaunlicherweise aus.

Diese eigenartige Stille veranlasst mich, in den folgenden Artikeln eine mögliche These zur Ursächlichkeit dieser ausbleibenden Reaktion aufzustellen und nach einem halben Jahr Bilanz zu ziehen, wie sich die SEO unter den Richtlinien des Eingangs umstrittenen Algorithmus, der mit dem Roll-Out von Google Penguin in Betrieb genommen wurde, entwickelt hat, um Anhand der gewonnenen Erkenntnisse die Lage der SEO-Branche einzuschätzen.

Auf Worte folgen Taten – Google realisiert eine umfassende Erneuerung des Algorithmus dessen Auswirkungen lange vor Roll-Out bekannt waren

Das Google den Suchalgorithmus im Zuge des Roll-Out von Penguin anpassen würde, war bereits sei langem bekannt, denn bereits nach dem Panda-Update in 2011, dessen Schwerpunkt bereits im Kampf gegen den Webspam lag, wurde offen von der zukünftig tendenziell stärker ausfallenden Bekämpfung von Spam und den Methoden der „Black-Hat SEO“ gesprochen. Das Update kündigte immerhin einen Wechsel der Paradigmen in der bisherigen Funktionsweise und Schwerpunktlagerung der Suchmaschine an und Google machte daraus kein Geheimnis.

Es hatte, das konnte man der damaligen Reaktion weiter Teile der SEO-Branche entnehmen, nur schlichtweg niemand den Vertretern des Konzerns abgenommen. Niemand schien zu glauben, dass Google mit Penguin tatsächlich ernst machen würde, schließlich wurde eine Verschärfung von Richtlinien und Ranking-Kriterien quasi alljährlich mit jedem neuen Update angekündigt, doch blieb eine ausschlaggebende Veränderung im Tagesgeschäft für die Branche mit Ausnahme der kurzen Phase der Anpassung wenn es einmal doch zu einer Änderung kam, dessen Auswirkungen auch für die SEO-Professionals bei der Ausübung ihrer Arbeit spürbar waren.

Jene, die der erneuten Kampfansage keinen Glauben schenkten und dem Konzern nicht abnahmen endlich Konsequenz beim Umgang mit Webspam und illegitimer SEO zu zeigen, geschweige denn einer partiellen Neuausrichtung des Suchalgorithmus, waren es genau diese Zeitgenossen, welche in Folge am lautesten Klage gegen das Unternehmen führten, spätestens als sich die Änderungen am Suchalgorithmus dann auch in den Rankings und auf den SERPs bemerkbar machten. Und sie feststellen mussten: „Dieses Mal macht Google ernst!“.

Mit einer Portion Empathie für die revoltierenden SEO-Professionals und die Situation aus deren Augen betrachtet erscheint die Ablehnung tiefgreifender Änderungen in einem über Jahre hinweg nahezu unveränderten beruflichen Umfeld als wenig attraktiv. Ziehe ich einen gewissen Hochmut mit ein, hatte man doch schließlich die Branche erst durch seine Arbeit definiert, ja geradezu Erfunden, fällt es mir leicht, die Gefühlswallungen als Mensch zu verstehen, wenngleich ich sie aus professioneller Sicht strikt ablehne.

Es bleibt subjektives Mitgefühl für die revoltierenden SEO-Professionals. Objektiv ist Penguin jedoch eine alternativlose Notwendigkeit für die Zukunft

Jedoch vom Standpunkt einer objektiven und möglichst wertfreien Warte waren die vorgebrachten Argumente der offiziellen Repräsentanten des Suchmaschinenkonzerns schlagend und ergeben sich als logische Weiterentwicklung der Algorithmen als vollkommen selbstverständlich, da sich mit den neuen Technologien der vergangenen Jahre und der Etablierung dieser, auch vollkommen neue Möglichkeiten einer immer präzisieren und durchdachten Methodik zur Erbringung von Suchergebnissen in höheren Qualitäten auftaten, welche die Auswertung der Daten sozialer Netzwerke bis auf die Individualebene hinab erlaubte, die in künftigen Ausgaben auf Suchergebnisseiten Berücksichtigung finden sollte.

Umso sinnvoller erscheint es daher, im nächsten Schritt die bisherigen Inhaltskonzepte abzulösen, da diese sich ausnahmslos an den Notwendigkeiten einer größtmöglichen Anpassung der optimalen Indexierung durch die Suchmaschine ausgesetzt sah. Der eigentliche Konsument, der Mensch, fiel bei diesem Konzept nämlich auf die hinteren Plätze zurück, weshalb die Ablösung der technischen Inhaltsgestaltung nur durch eine Neuausrichtung der Content-Gestaltung mit dem menschlichen Nutzer als Mittelpunkt der Aufmerksamkeit zwingend erfolgen musste.

Förderung der Qualität von bereitgestelltem Content als zukunftssicheres Modell. Das Vorgehen gegen Webspam und Black-Hat SEO wird konsequent in die Tat umgesetzt

Diesem Konzept folgte sodann die Verlagerung der im Rahmen des Rankingprozesses neu definierten Relevanz-Kriterien bei der Bewertung von Web Content, der die Ausrichtung auf hochwertige und keyword-relevante Inhalte, besonders aus fachkundiger oder anderweitig qualifizierten Quellen mit einer positiven Entwicklung der Platzierung in den SERPs, zuzüglich von Modifikatoren durch soziale Elemente wie Empfehlungen, Verweilzeit und Teilen der Inhalte auf Plattformen sozialer Netzwerke, anhand derer eine Prädiktion der Relevanz des bereitgestellten Inhalts präziser dargestellt werde könnte. Gleichzeitig würde mit dieser Änderung in der Verfahrensweise ein sanfter, wenngleich unausweichlicher Anpassungsdruck hin zur neuen Inhaltskonzeption erzeugt, der die Zielsetzung in einen greifbaren Zeitraum fassbar werden ließ und somit Erfolg in der Umsetzung versprach.

Durch den Einsatz weiterentwickelter Prüfmethoden würde der Suchalgorithmus mit höchsten Erkennungsraten und Fehlindikationen im niedrigen Promillebereich in die Lage versetzt den neuartigen Formen der Manipulation von Suchergebnisplatzierungen, die vorherige Versionen nicht zweifelsfrei feststellen konnte, erfolgreich entgegen zu wirken. Automatisierte Prozesse führten sodann nach Feststellung eines Manipulationsversuches in Echtzeit zur Einleitung von Sanktionen, gegebenenfalls auch der Übergabe an die Prüfer des Google Webspam Team um eine langfristige oder permanente Ausgliederung der Erfassten Webseite aus dem Suchindex von Google zu veranlassen.

Eine fehlerfreie Erkennung von Manipulationsversuchen und unnatürlicher Entwicklungsmuster verbessert die Konsistenz der Google SERPs

Mittels Datenabgleichs würde der Algorithmus in der Lage sein, eine zuverlässige Erkennung von unnatürlichen Entwicklungsmustern beim Aufbau der Backlink-Strukturen zu prüfender Webseiten durchzuführen und somit jede Form von Manipulationsversuch bereits im Entwicklungsstadium zu erkennen noch bevor die zur Manipulation ausgerichtete Webseite einen Einfluss auf die Qualität der Suchergebnisse im vom Optimierer angestrebten Zielbereich nehmen könnte.

So präsentierte sich mir der langfristige Plan zur Entwicklung zeitgemäßer Erhebungsmethoden und Verhinderung von manipulativen Einflussnahmen, die das Gebrauchserlebnis als unausweichliche Schnittmenge der Google zugrunde liegenden Methode schmälerte. Ein Plan, der hinter den eingreifenden Veränderungen unter dem Projektnamen „Penguin“ steckte und die Konkurrenzfähigkeit und Qualitätssicherung der von Google bereitgestellten Suchergebnisse auch in naher Zukunft sichern sollte.

Lesen Sie nächste Woche einen weiteren Teil der Serie Ein halbes Jahr „Google Penguin“

Die komplette Serie finden Sie hier:

Es bleiben zu dieser Teilbetrachtung der Figur des „Over optimizating“-SEO nur die Widerlegung der mit der Kriminalisierung einer, von Google als übermäßig erklärten Ausschöpfung von Potential: Ist der Webmaster unfähig, schadet er nur sich selbst. Ist der Webmaster begabt, verletzt er keine Richtlinien und nutzt die Mechanismen, die durch Google selbst durch die unterschiedliche Bewertung von Webseiten erst bereitgestellt hat. Müsste es nicht sogar das Ziel jedes SEO-Professionals sein, einmal im Leben, ob als Gesellenstück oder Meisterwerk, sich genau an ein solches Projekt zu setzen? Und zuletzt bleibt noch die Frage: “Mr. Cutts, welches Problem haben sie mit der SEO sowohl als Berufsfeld als auch als Konzept?“

Es bleiben zu dieser Teilbetrachtung der Figur des „Over optimizating“-SEO nur die Widerlegung der mit der Kriminalisierung einer, von Google als übermäßig erklärten Ausschöpfung von Potential: Ist der Webmaster unfähig, schadet er nur sich selbst. Ist der Webmaster begabt, verletzt er keine Richtlinien und nutzt die Mechanismen, die durch Google selbst durch die unterschiedliche Bewertung von Webseiten erst bereitgestellt hat. Müsste es nicht sogar das Ziel jedes SEO-Professionals sein, einmal im Leben, ob als Gesellenstück oder Meisterwerk, sich genau an ein solches Projekt zu setzen? Und zuletzt bleibt noch die Frage: “Mr. Cutts, welches Problem haben sie mit der SEO sowohl als Berufsfeld als auch als Konzept?“ Google standardisiert das Internet – Das ist eine Erkenntnis, der man sich nur schwerlich entziehen kann. Durch eine Vielzahl an Projekten und der Mitarbeit in vielen Gremien hat das Unternehmen seit seiner Gründung Mitte der 1990er für eine klare Standardisierung des Internets in vielen Belangen, von der Definition von HTML bis hin zur Einführung neuer Technologien zur Darstellung multimedialer Inhalte gewirkt, zum Vorteil aller.

Google standardisiert das Internet – Das ist eine Erkenntnis, der man sich nur schwerlich entziehen kann. Durch eine Vielzahl an Projekten und der Mitarbeit in vielen Gremien hat das Unternehmen seit seiner Gründung Mitte der 1990er für eine klare Standardisierung des Internets in vielen Belangen, von der Definition von HTML bis hin zur Einführung neuer Technologien zur Darstellung multimedialer Inhalte gewirkt, zum Vorteil aller. Seit Microsoft Mitte 2009 die Suchmaschine „Bing“ gestartet hat, konnte sich der Onlinedienst zu einem gut durchdachten Werkzeug entwickeln. Dennoch blieb er in puncto Marktanteile bisher immer weit hinter seinem Rivalen Google liegen. Wie drastisch die Unterschiede in der Kundennutzung sind, haben wir in einem unserer letzten Artikel gezeigt. Doch nun bläst Microsoft (mal wieder) zum Gegenangriff. Der Software-Konzern plant die Integration von Social Content in die Suchergebnisse. Das bedeutet, dass relevante Inhalte von sozialen Netzwerken wie Facebook und Twitter bei Suchanfragen angezeigt werden. Damit würde Bing den Usern mehr Informationen bereitstellen als Google und idealerweise an Attraktivität gewinnen. Zusätzlich will Bing neue Algorithmen einführen, die eine höhere Treffsicherheit ermöglichen sollen. Mit diesen Neuerungen könnte Suchmaschinenoptimierung in sozialen Netzwerken an Bedeutung gewinnen. Zugleich soll es auch Veränderungen im Bereich Funktionalität geben. So soll der Service in Zukunft nicht einfach mehr nur der Suche bzw. dem Finden von Inhalten dienen, sondern auch aktiv an der Handlungsplanung der User beteiligt sein. Und auch die Facebook-Freunde werden aktiv in de Suchprozess einbezogen.

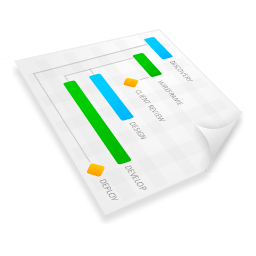

Seit Microsoft Mitte 2009 die Suchmaschine „Bing“ gestartet hat, konnte sich der Onlinedienst zu einem gut durchdachten Werkzeug entwickeln. Dennoch blieb er in puncto Marktanteile bisher immer weit hinter seinem Rivalen Google liegen. Wie drastisch die Unterschiede in der Kundennutzung sind, haben wir in einem unserer letzten Artikel gezeigt. Doch nun bläst Microsoft (mal wieder) zum Gegenangriff. Der Software-Konzern plant die Integration von Social Content in die Suchergebnisse. Das bedeutet, dass relevante Inhalte von sozialen Netzwerken wie Facebook und Twitter bei Suchanfragen angezeigt werden. Damit würde Bing den Usern mehr Informationen bereitstellen als Google und idealerweise an Attraktivität gewinnen. Zusätzlich will Bing neue Algorithmen einführen, die eine höhere Treffsicherheit ermöglichen sollen. Mit diesen Neuerungen könnte Suchmaschinenoptimierung in sozialen Netzwerken an Bedeutung gewinnen. Zugleich soll es auch Veränderungen im Bereich Funktionalität geben. So soll der Service in Zukunft nicht einfach mehr nur der Suche bzw. dem Finden von Inhalten dienen, sondern auch aktiv an der Handlungsplanung der User beteiligt sein. Und auch die Facebook-Freunde werden aktiv in de Suchprozess einbezogen. Die Suchmaschinenbranche ist ein hart umkämpfter Markt, der von einigen großen Namen angeführt wird. Dazu zählen in erster Linie Yahoo, Bing und Google. Doch das Kräfteverhältnis zwischen den Anbietern ist nicht ausgeglichen, nicht alle bekommen ein gleich großes Stück vom „Markt“-Kuchen. Das lässt sich sehr gut lässt anhand der USA belegen. Laut Angaben des Marktforschungsunternehmens ComScore gaben die Menschen dort im Jahr 2011 insgesamt 17.106 Milliarden (!) Anfragen in die Suchmaschinen ein. 66,5 Prozent der Anfragen im April liefen über Google. Damit hängt der Internet-Riese seine Konkurrenz locker ab: Auf Platz 2 folgen die Microsoft-Angebote mit lediglich 15, 4 % der Suchanfragen. Yahoo, Ask und andere Anbieter müssen sich mit noch geringeren Werten zufrieden geben. Zum Vergleich: in Deutschland ist die Situation ähnlich eindeutig, wenn nicht sogar noch drastischer aus. Wie das Focus-Magazin berichtet, konnte Google hier seinen Marktanteil in den vergangenen Jahren auf rund 96 Prozent ausbauen. Bing hingegen hat von seinem ohnehin schon geringen Anteil von 2,7 Prozent innerhalb eines Jahres noch 1,6 Prozent verloren. Auch Yahoos

Die Suchmaschinenbranche ist ein hart umkämpfter Markt, der von einigen großen Namen angeführt wird. Dazu zählen in erster Linie Yahoo, Bing und Google. Doch das Kräfteverhältnis zwischen den Anbietern ist nicht ausgeglichen, nicht alle bekommen ein gleich großes Stück vom „Markt“-Kuchen. Das lässt sich sehr gut lässt anhand der USA belegen. Laut Angaben des Marktforschungsunternehmens ComScore gaben die Menschen dort im Jahr 2011 insgesamt 17.106 Milliarden (!) Anfragen in die Suchmaschinen ein. 66,5 Prozent der Anfragen im April liefen über Google. Damit hängt der Internet-Riese seine Konkurrenz locker ab: Auf Platz 2 folgen die Microsoft-Angebote mit lediglich 15, 4 % der Suchanfragen. Yahoo, Ask und andere Anbieter müssen sich mit noch geringeren Werten zufrieden geben. Zum Vergleich: in Deutschland ist die Situation ähnlich eindeutig, wenn nicht sogar noch drastischer aus. Wie das Focus-Magazin berichtet, konnte Google hier seinen Marktanteil in den vergangenen Jahren auf rund 96 Prozent ausbauen. Bing hingegen hat von seinem ohnehin schon geringen Anteil von 2,7 Prozent innerhalb eines Jahres noch 1,6 Prozent verloren. Auch Yahoos  Unlängst holte Google in einem lange vorbereiten Update seiner Suchalgorithmen zum vermeintlich großen Schlag gegen die Betreiber von Linkfarmen und Keyword-Stuffern aus und bearbeitet die Darstellung der Suche für eine bessere Bedienbarkeit der Suchmaske und der Ergebnisseite: Mit ganzen 52 Änderungen, darunter viele Anpassungen im Detail, wie etwa die im folgenden erwähnten Updates und Bugfixes für die Google-Suche:

Unlängst holte Google in einem lange vorbereiten Update seiner Suchalgorithmen zum vermeintlich großen Schlag gegen die Betreiber von Linkfarmen und Keyword-Stuffern aus und bearbeitet die Darstellung der Suche für eine bessere Bedienbarkeit der Suchmaske und der Ergebnisseite: Mit ganzen 52 Änderungen, darunter viele Anpassungen im Detail, wie etwa die im folgenden erwähnten Updates und Bugfixes für die Google-Suche: In der modernen Internet-Ära findet immer häufiger die Verbindung von klassischem Webauftritt und Social-Media-Präsenz statt. Unternehmen und Privatpersonen teilen Inhalte ihrer Blogs und Homepages regelmäßig bei Facebook, Twitter & Co. Gleichzeitig implementieren sie Social Widgets auf den Websites, um den Präsentationskreis zu schließen. Spätestens seit Google mit seinem Network-Service Google+ selbst einen Fuß ins Social Web gesetzt hat, ist die

In der modernen Internet-Ära findet immer häufiger die Verbindung von klassischem Webauftritt und Social-Media-Präsenz statt. Unternehmen und Privatpersonen teilen Inhalte ihrer Blogs und Homepages regelmäßig bei Facebook, Twitter & Co. Gleichzeitig implementieren sie Social Widgets auf den Websites, um den Präsentationskreis zu schließen. Spätestens seit Google mit seinem Network-Service Google+ selbst einen Fuß ins Social Web gesetzt hat, ist die  Das Social Web bietet eine große Auswahl an Netzwerk-Plattformen, die den

Das Social Web bietet eine große Auswahl an Netzwerk-Plattformen, die den  Das Wachstum der

Das Wachstum der